Como funciona a Ethernet

por Nick Pidgeon - traduzido por HowStuffWorks Brasil

Introdução

O acesso eficiente e confiável à informação é um aspecto importante do mundo dos negócios. Arquivos e montanhas de papel foram substituídos por computadores, que armazenam e gerenciam, eletronicamente, a informação. Um trabalho pode ser realizado por duas ou mais pessoas que moram em lugares completamente diferentes. Centenas de trabalhadores de uma empresa podem revisar simultaneamente uma informação disponível online.

As tecnologias de rede dos computadores são a cola que une esses elementos. A Internet pública permite que os vendedores de produtos e serviços disponibilizem informação para seus parceiros e consumidores. A rede global de computadores conhecida como Internet permite que as pessoas comprem livros, roupas e até carros. Também é possível colocar esses itens em um leilão, quando não são mais desejados.

Neste artigo, vamos examinar detalhadamente as redes e, em particular, o padrão de rede Ethernet. Você vai entender como todos esses computadores se conectam.

Por que rede?

Uma rede permite a troca de informações (envio e recebimento) entre computadores. Talvez nós nem tenhamos idéia da quantidade de vezes que acessamos informações em redes de computador. A Internetcertamente é o maior exemplo de rede de computadores, com milhões de máquinas conectadas ao redor do mundo, mas as pequenas redes desempenham um papel importante na busca diária de informações. Muitas bibliotecas públicas substituíram os cartões em papel por terminais de computador. Assim, é mais fácil e rápido procurar os livros. Os aeroportos têm inúmeras telas que exibem informações sobre vôos. Muitas lojas têm computadores especializados que controlam transações de pontos-de-venda. Em cada um desses casos, as redes oferecem diferentes dispositivos em diversas localidades que acessam uma informação compartilhada.

Antes de conhecer os detalhes de um padrão de rede como a Ethernet precisamos entender alguns termos básicos e classificações que descrevem e diferenciam as diferentes tecnologias de rede. Vamos começar!

Rede local x rede de longa distância

As tecnologias de rede podem ser divididas em dois grupos básicos:

- Rede local, na qual as tecnologias LAN (Local Area Network) conectam muitos dispositivos que estão relativamente próximos, geralmente no mesmo prédio. Os terminais de uma livraria que exibem informações sobre um livro estão conectados a uma rede local.

- Rede de longa distância, na qual as tecnologias WAN (Wide Area Network) conectam um número menor de dispositivos que podem estar separados por muitos quilômetros. Por exemplo, se duas livrarias situadas em bairros diferentes quiserem compartilhar a informação de seu catálogo de livros, elas devem usar uma tecnologia de rede de longa distância. Pode-se usar uma linha dedicada, alugada da companhia telefônica.

Em comparação às WANs, as LANs são mais rápidas e confiáveis. A tecnologia, porém, se desenvolve rapidamente, e as diferenças entre WAN e LAN estão cada vez menores. Os cabos de fibra ótica permitem a conexão de dispositivos LAN separados por quilômetros de distância. Esses cabos também melhoram a velocidade e a confiabilidade das redes WAN.

A Ethernet

Em 1973, os pesquisadores Bob Metcalfe e David Boggs, do Xerox Corporation's Palo Alto Research Center (mais conhecido como PARC), e criaram e testaram a primeira rede Ethernet. Metcalfe tentava conectar o computador "Alto" da Xerox a uma impressora e acabou desenvolvendo um método físico de cabeamento que conectava os dispositivos na Ethernet. Ele também criou os padrões de comunicação em cabos. Desde então, a Ethernet se tornou a tecnologia de redes mais popular do mundo. Muitos dos problemas da Ethernet são parecidos com os problemas das outras tecnologias de rede. Compreender o funcionamento da Ethernet dará a você embasamento para entender as redes em geral.

Com o amadurecimento das redes, o padrão Ethernet cresceu para agregar novas tecnologias. Mas os mecanismos de operação de todas as redes Ethernet atuais se baseiam no sistema original de Metcalfe. O conceito original de Ethernet é: comunicação compartilhada por um único cabo para todos os dispositivos da rede. Uma vez que o dispositivo está conectado a esse cabo, ele tem a capacidade de se comunicar com qualquer outro dispositivo. Isso permite que a rede se expanda para acomodar novos dispositivos sem ter de modificar os dispositivos antigos.

Informações básicas sobre a Ethernet

A Ethernet é uma tecnologia de rede local. Essas redes normalmente operam num mesmo prédio e conectam dispositivos próximos. No início podia haver no máximo algumas centenas de metros de cabos separando dispositivos numa Ethernet, tornando difícil conectar locais muito distantes geograficamente. Avanços recentes da tecnologia conseguiram aumentar essas distâncias, e as redes Ethernet atuais podem cobrir dezenas de quilômetros.

Protocolos

Na área de redes, o termo protocolo se refere a um conjunto de regras que regem as comunicações. Protocolos são a linguagem dos computadores. Seguindo esse raciocínio, dois dispositivos de uma rede precisam entender o mesmo protocolo para poder se comunicar.

Terminologia da Ethernet

Regras simples regem a operação básica da Ethernet. Para compreender essas regras, é importante conhecer a terminologia básica da Ethernet.

- meio - dispositivos Ethernet se conectam a um meio comum que fornece um caminho para os sinais eletrônicos. Historicamente, esse meio é um cabo coaxial de cobre, mas hoje se utiliza cabeamento de par trançado ou fibra ótica.

- segmentos - um único meio compartilhado é um segmento Ethernet.

- nó - dispositivo que se conecta ao segmento.

- frame - os nós se comunicam por meio de mensagens curtas chamadas frames, que são blocos de informação de tamanho variável.

Pense em um frame como se fosse uma frase na linguagem humana. Em português, obedecemos a regras para construir as frases. Sabemos que todas as frases devem possuir um sentido completo. O protocolo Ethernet especifica um conjunto de regras para construir os frames. Existe um comprimento mínimo e máximo para os frames e um conjunto necessário de trechos de informação que devem aparecer no frame. Por exemplo, cada frame deve incluir um endereço de destino e um endereço de envio, que identificam respectivamente o destinatário e o remetente da mensagem. O endereço identifica um nó único, da mesma forma que um nome identifica uma pessoa - dois dispositivos Ethernet nunca têm o mesmo endereço.

O meio Ethernet

Como um sinal no meio Ethernet alcança todos os nós conectados, o endereço de destino desempenha um papel fundamental para identificar o destinatário do frame.

Por exemplo, na figura acima, quando o computador B transmite para a impressora C, os computadores A e D ainda vão receber e examinar o frame. Entretanto, quando a primeira estação recebe o frame, ela verifica o endereço de destino para saber se o frame foi endereçado a ela. Se não foi, a estação descarta o frame sem examinar o conteúdo.

Um aspecto interessante do endereçamento Ethernet é a implementação do endereço broadcast. Um frame com endereço de destino igual ao endereço broadcast (também chamado simplesmente de broadcast) é direcionado para cada nó da rede, e cada nó vai receber e processar esse tipo de frame.

CSMA/CD

A sigla CSMA/CD significa, em inglês, carrier-sense multiple access with collision detection (acesso múltiplo com detecção de portadora e detecção de colisão) e descreve como o protocolo de Ethernet regula a comunicação entre os nós de uma rede. A expressão pode intimidar, mas se analisarmos os conceitos de seus componentes, separadamente, vamos ver que ele descreve regras muito similares àquelas que as pessoas utilizam em conversações civilizadas. Para ajudar a ilustrar a operação da Ethernet, vamos usar uma analogia: uma conversação à mesa de jantar.

Nosso segmento Ethernet é a mesa de jantar, e os nós são as pessoas conversando educadamente. A expressão múltiplo acesso (multiple access) fala sobre o que acabamos de discutir. Quando uma estação de Ethernet transmite, todas as estações no meio ouvem a transmissão. Da mesma maneira que quando uma pessoa fala, todo mundo escuta.

Agora vamos imaginar que você esteja à mesa e tenha alguma coisa a dizer. No momento, entretanto, existe uma pessoa falando. Já que essa é uma conversação educada, em vez de imediatamente falar e interromper o outro você espera até que ele termine de falar. Na terminologia da Ethernet, esse processo se chama carrier sense (detecção de portadora). Antes de uma estação começar a transmitir, ela "ouve" o meio para saber se outra estação está transmitindo. Se o meio estiver em silêncio, a estação reconhece que esse é o momento apropriado para transmitir.

Detecção de colisão

O acesso de múltiplos dispositivos de rede é uma boa maneira de começarmos a explorar as limitações da Ethernet, mas existe outro cenário que ainda temos de analisar. Vamos criar uma analogia da mesa de jantar e imaginar que existe um silêncio momentâneo na conversação. Você e eu temos coisas a falar e ambos sentimos o "peso do silêncio". Para resolver isso, começamos a falar quase ao mesmo tempo. Na terminologia da Ethernet, ocorre uma colisão quando os dois tentam falar ao mesmo tempo.

Em nosso caso, podemos resolver a situação de maneira civilizada. Após a percepção de que estávamos falando ao mesmo tempo, um de nós pára de falar para escutar o outro. Os nós da Ethernet também escutam o meio enquanto transmitem, para ter certeza de que são a única estação transmissora naquele momento. Se as estações começam a ouvir sua própria transmissão de forma distorcida ou misturada com a de outra estação sabem que uma colisão aconteceu. Às vezes, um segmento de Ethernet é chamado de domínio de colisão porque duas estações no segmento não podem transmitir ao mesmo tempo sem causar uma colisão. Quando as estações detectam uma colisão, elas interrompem a transmissão, esperam durante um período aleatório e tentam transmitir novamente quando detectam silêncio no meio.

A pausa aleatória e a repetição do envio do sinal representam parte importante do protocolo. Se as duas estações colidem quando estão transmitindo, então ambas terão de transmitir novamente. Na próxima oportunidade de transmissão, as estações envolvidas na colisão anterior terão dados prontos para transmitir. Se elas transmitissem novamente na primeira oportunidade, colidiriam de novo. Por isso existe um tempo de espera aleatório. Assim, dificilmente as duas estações vão continuar colidindo por muito tempo.

As limitações da Ethernet

Um cabo compartilhado é a base para uma rede Ethernet completa, o que discutimos anteriormente. De qualquer forma, há limites práticos para o tamanho de nossa rede Ethernet nesse caso. A primeira preocupação é o comprimento do cabo compartilhado.

Os sinais elétricos se propagam muito rapidamente pelo cabo, mas se tornam mais fracos com a distância, e a interferência de aparelhos elétricos (como lâmpadas fluorescentes) pode prejudicar o sinal. Um cabo de rede deve ser curto o suficiente para que os dispositivos em cada ponta recebam o sinal sem interferências e sem atraso. Esse é o limite da distância máxima que separa dois dispositivos (também conhecido como diâmetro da rede) em uma rede Ethernet. Além disso, como em CSMA/CD um dispositivo único só pode transmitir num determinado momento, existem limites práticos para o número de dispositivos que podem coexistir em uma mesma rede. Se você conectar muitos dispositivos a um mesmo segmento compartilhado, a contenção do meio aumenta. Cada dispositivo terá de esperar um longo tempo antes de conseguir transmitir.

Os engenheiros desenvolveram uma série de dispositivos de rede que aliviam esses problemas. Muitos desses dispositivos não são específicos para a Ethernet, sendo utilizados em outras tecnologias também.

Repetidores

O primeiro meio popular de Ethernet foi um cabo coaxial de cobre conhecido como "thicknet." O comprimento máximo desse cabo era de 500 metros. Em grandes prédios ou campus de universidades, um cabo de 500 metros nem sempre era suficiente. Um repetidor resolve esse problema.

Os repetidores conectam múltiplos segmentos de Ethernet, ouvindo cada segmento e repetindo o sinal ouvido para todos os outros segmentos conectados. O uso desses aparelhos permite aumentar significativamente o diâmetro de uma rede.

Segmentação

Em nossa analogia da mesa, havia poucas pessoas à mesa, situação em que ter só uma pessoa falando de cada vez não chega a provocar problemas de comunicação. Mas o que aconteceria se fosse muita gente reunida e só um pudesse falar?

Na prática, sabemos que essa analogia gera situações como a que veremos a seguir. Em grandes grupos de pessoas, é normal que aconteçam diferentes conversas simultaneamente. Se, em uma sala lotada somente uma pessoa pudesse falar a qualquer momento, muitas pessoas ficariam frustradas esperando um momento para falar. Para os humanos, o problema se corrigiria automaticamente: O alcance da voz humana é limitado e o ouvido consegue focar em uma conversa específica mesmo que esteja em um ambiente barulhento. Por isso, é comum que existam diversas conversas simultâneas em uma mesma sala. Isso não acontece com os cabos de rede, já que eles conseguem carregar sinais rapidamente e de forma eficiente por longas distâncias.

As redes Ethernet enfrentaram problemas de congestionamento ao ficarem maiores. Se há um grande número de estações conectadas a um mesmo segmento e cada uma gera uma quantidade considerável de tráfego, muitas estações tentarão transmitir assim que houver uma oportunidade. Nessas circunstâncias, as colisões se tornariam mais freqüentes e poderiam prejudicar outras transmissões, que levariam mais tempo para ser concluídas. Um jeito de reduzir os congestionamentos seria dividir cada segmento em múltiplos segmentos e assim criar múltiplos domínios de colisão. Essa solução cria um problema diferente, já que esses segmentos separados não conseguem trocar informação uns com os outros.

Pontes

Para aliviar os problemas da segmentação, as redes Ethernet implementaram as pontes. Elas conectam dois ou mais segmentos de rede, e assim aumentam o diâmetro da rede da mesma forma que os repetidores, mas as pontes também ajudam a regular o tráfego. As pontes podem enviar e receber transmissões do mesmo jeito que qualquer outro nó, mas elas não funcionam da mesma maneira que um nó comum. A ponte não gera nenhum tráfego (como os repetidores), apenas ecoa o que ouve das outras estações. (Essa última afirmação não é 100% precisa: as pontes na verdade criam um frame especial Ethernet que permite que elas se comuniquem com outras pontes, mas esse assunto não é analisado neste artigo).

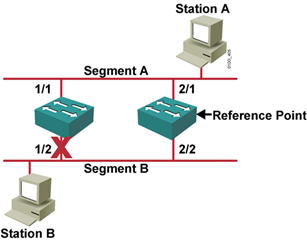

Uma das características do meio compartilhado de acesso múltiplo da Ethernet é que toda estação conectada recebe qualquer transmissão, mesmo que a transmissão não seja endereçada à estação. As pontes usam esse recurso para distribuir o tráfego entre os segmentos. Na figura acima, a ponte conecta os segmentos 1 e 2. Se as estações A e B transmitirem, a ponte também receberá a transmissão no segmento 1. Como a ponte deveria responder a esse tráfego? Ela poderia transmitir automaticamente o frame para o segmento 2, como um repetidor. Isso não aliviaria o congestionamento, já que a rede estaria se comportando como um longo segmento.

Um dos objetivos da ponte é reduzir o tráfego desnecessário nos 2 segmentos. Ela examina o endereço de destino do frame antes de decidir o que fazer com ele. Se o endereço de destino está relacionado com a estação A ou B, o frame não precisa aparecer no segmento 2. Nesse caso, a ponte não faz nada. Na verdade, a ponte filtra ou descarta o frame. Se o endereço de destino é o da estação C ou D, ou se é um endereço broadcast, a ponte vai transmitir ou encaminhar o frame para o segmento 2. Ao encaminhar os pacotes, a ponte permite que qualquer um dos quatro dispositivos se comunique. Ao filtrar os pacotes, a ponte permite que a estação A transmita para a estação B ao mesmo tempo em que a estação C transmite para a estação D; assim, duas conversas acontecem simultaneamente.

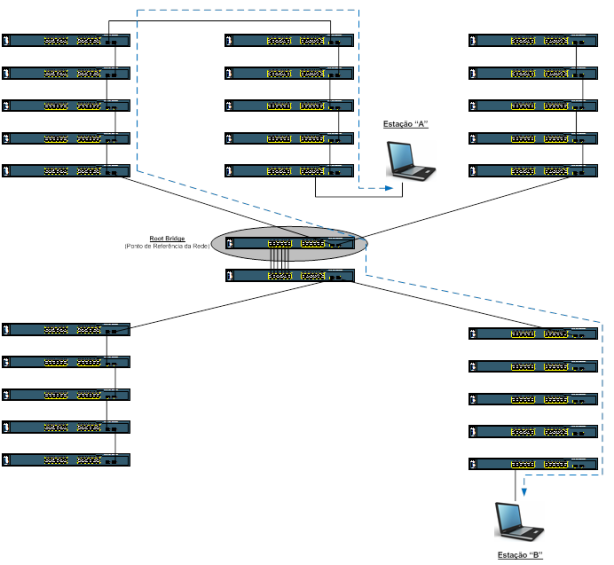

Switches são versões modernas das pontes. Eles funcionam de maneira semelhante, mas oferecem umsegmento dedicado para cada nó da rede (mais informações sobre os switches a seguir).

Roteadores: segmentação lógica

As pontes podem reduzir o congestionamento ao permitir múltiplas conversações simultâneas em segmentos diferentes, mas elas também têm seus limites na segmentação do tráfego.

Uma característica importante das pontes é que elas encaminham endereços broadcast da Ethernet para todos os segmentos conectados. Isso é necessário, já que os endereços broadcast são endereçados para todos os nós da rede. O problema é que as redes em ponte podem se tornar muito grandes. Quando um grande número de estações transmite em broadcast numa rede em ponte, o congestionamento pode ser imenso. Isso criaria uma situação semelhante a um congestionamento em um segmento simples.

Os roteadores são componentes avançados de rede que podem dividir uma rede em duas redes lógicas independentes. Os endereços broadcast da Ethernet cruzam as pontes em busca de cada nó da rede, mas não atravessam os roteadores, porque os roteadores criam uma barreira lógica para a rede.

Os roteadores operam com protocolos independentes da tecnologia específica da rede, como Ethernet ou token ring (vamos falar sobre o token ring mais adiante). Isso permite que os roteadores interconectem várias tecnologias de rede (local ou de longa distância) e foi um dos componentes que facilitaram a conexão de vários dispositivos em várias partes do mundo para formar a Internet.

Consulte Como funcionam os roteadores para obter informações detalhadas sobre essa tecnologia.

Ethernet comutada

As redes Ethernet modernas não se parecem em nada com as versões mais antigas. Em redes Ethernet antigas, as estações eram conectadas por longos cabos coaxiais. Nas redes modernas se usa cabeamento de par trançado ou fibra ótica para conectar as estações em um padrão radial. Enquanto as redes antigas transmitiam dados a uma velocidade de 10 megabits por segundo (Mbps), as redes modernas podem operar a 100 ou até 1.000 Mbps.

Talvez o maior avanço das redes Ethernet atuais seja o uso da Ethernet comutada. As redes comutadas substituem a mídia compartilhada utilizada pela Ethernet antiga por um segmento dedicado para cada estação. Esses segmentos se conectam a um switch, que funciona de maneira parecida com uma ponte Ethernet, mas pode conectar mais segmentos de estações únicas. Alguns switches podem suportar centenas de segmentos dedicados. Como os únicos dispositivos nos segmentos são o switch e a estação final, os switches recebem todas as transmissões antes de elas chegarem ao nó seguinte. O switch então encaminha o frame para o segmento apropriado, do mesmo jeito que uma ponte o faria. Como cada segmento contém um único nó, o frame só alcança o destinatário desejado. Esse procedimento permite múltiplas conversações numa rede comutada (consulte Como funcionam os switches LAN - rede de comunicação local - para aprender mais sobre a tecnologia de switches).

Ethernet full-duplex

A Ethernet comutada gerou outro avanço: a Ethernet full-duplex. Full-duplex é uma expressão de comunicação de dados que se refere à capacidade de enviar e receber dados ao mesmo tempo.

A Ethernet antiga é half-duplex, ou seja, a informação só pode se mover em uma direção por vez. Numa rede totalmente comutada, os nós só se comunicam com o switch e não diretamente com outro nó. As redes comutadas podem utilizar cabeamento de par trançado ou fibra ótica. Ambos utilizam condutores independentes para enviar e receber dados. Nesse tipo de ambiente, as estações Ethernet podem esquecer o processo de detecção de colisão e transmitir à vontade, já que elas são os únicos dispositivos que podem acessar o meio. Isso permite que as estações finais transmitam para o switch ao mesmo tempo em que o switch transmite para elas. Assim, o ambiente se torna livre de colisões.

Ethernet ou 802.3?

Você já deve ter ouvido o termo 802.3 usado em lugar de ou em conjunto com o termo Ethernet. "Ethernet" se refere originalmente a uma implementação de rede padronizada pela Digital, Intel e Xerox - por esse motivo, ela também é conhecida como padrão DIX.

Em fevereiro de 1980, o Institute of Electrical and Electronics Engineers, ou IEEE (se pronuncia "I três E"), criou um comitê para padronizar as tecnologias de rede. O IEEE batizou esse comitê como grupo de trabalho 802. O nome foi baseado no ano e no mês de formação do grupo. Subcomitês do grupo de trabalho 802 pesquisavam separadamente diferentes aspectos das redes. O IEEE definiu cada subcomitê numerando-o como 802.X, em que X representava um número único para cada subcomitê. O grupo 802.3 padronizou a operação de rede CSMA/CD que tinha função equivalente à Ethernet DIX.

Ethernet e 802.3 são levemente diferentes em sua terminologia e formato de dados de seus frames, mas são idênticos na maioria dos aspectos. Hoje, o termo Ethernet se refere genericamente tanto à implementação DIX Ethernet quanto à padronização IEEE 802.3.

Tecnologias alternativas de redes: token ring

Além da Ethernet, a alternativa mais comum de redes é uma tecnologia desenvolvida pela IBM, chamadatoken ring. A Ethernet depende de espaços aleatórios entre as transmissões para regular o acesso ao meio, ao passo que o token ring implementa um sistema de acesso ordenado e estrito. Uma rede token ring organiza os nós em um anel lógico, como demonstrado a seguir. Os nós encaminham os frames em uma direção em volta do anel e removem o frame quando ele dá uma volta completa no anel.

- O anel é iniciado criando um token (ou ficha), que é um tipo especial de frame que dá à estação a permissão para transmitir.

- O token circula no anel como qualquer outro frame até encontrar uma estação que queira transmitir dados.

- Essa estação "captura" o token e substitui o frame do token por um frame que carrega dados. Esse frame circula na rede.

- Quando esse frame de dados retorna à estação transmissora, a estação remove o frame de dados, cria um novo token e encaminha esse token para o próximo nó do anel.

Os nós da rede token ring não buscam um sinal que carrega dados ou colisões. A presença do token assegura que a estação pode transmitir dados sem que outra estação a interrompa. As estações só transmitem um único frame de dados antes de passar o token; por isso, cada estação no anel terá uma chance para transmitir dados de maneira estrita e justa. Geralmente, as redes token ring transmitem dados numa velocidade de 4 ou 16 Mbps.

O padrão FDDI (Fiber-distributed data interface) é outra tecnologia que utiliza tokens e que opera em um par de anéis de fibra ótica. Cada anel passa um token em direções opostas. As redes FDDI ofereciam velocidades de transmissão de 100 Mbps. Inicialmente, esse tipo de padrão se tornou muito popular para as redes de alta velocidade. Com a criação da Ethernet de 100 Mbps, que é mais barata e mais fácil de se administrar, o padrão FDDI se tornou menos popular.

Tecnologia alternativa: modo de transferência assíncrono

Uma última tecnologia de rede que deve ser mencionada é o modo de transferência assíncrono(asynchronous transfer mode ou ATM). O ATM fica no limite entre as redes locais e as redes de longa distância. Esse tipo de rede pode conectar muitos dispositivos diferentes com alta confiabilidade e velocidade e cobre longas distâncias. As redes ATM são indicadas não só para dados, mas também para tráfego de voz e vídeo. Esse tipo de rede é bastante versátil e expansível. Essa tecnologia ainda não ganhou a aceitação esperada, mas é uma tecnologia bastante sólida e confiável.

A popularidade da Ethernet continua aumentando. Com quase 30 anos de aceitação da indústria, o padrão é bastante conhecido e estudado; por isso, a instalação e a resolução de problemas se tornam mais fáceis. Outras tecnologias avançaram, mas a Ethernet se torna cada vez mais rápida e funcional.