Autor: diakonov

Fonte: http://forum.clubedohardware.com.br/recuperacao-hd-seagate/696794

Resolvi postar esse tópico pois meu HD de 750GB da Seagate, série 7200.11 pifou por defeito do firmware dessa série e com muito esforço e ansiedade consegui reverter o dano através de fóruns da internet. Infelizmente, mesmo para as séries mais recentes de HDs de alta capacidade de todas as marcas, temos relatos terríveis de HDs morrendo depois de poucos meses de uso o que nos obriga a fazer backup de centenas de gigabytes com centenas de DVDs de 4.5Gb.

A solução que colocarei aqui foi obtida de diversos fóruns na internet, em português e em inglês, mas com partes mal explicadas e conflitantes ou faltando e por isso resolvi postar esse tópico.

Temos basicamente 2 tipos de defeitos possíveis devido ao firmware. Eu irei postar APENAS a solução que eu testei para o MEU problema específico para evitar erros. Também eu NAO garanto que esse meu procedimento dê certo, temos inúmeros relatos de erros e sucessos. Para mais informações técnicas dos defeitos consulte os links abaixo.

Os fóruns de internet pesquisados foram os seguintes:

http://www.overclock.net/hard-drives...-fix-pics.html

http://www.msfn.org/board/index.php?...128807&st=1000

http://www.guiadohardware.net/comuni...ml#post4373693

http://sites.google.com/site/seagatefix/

SUGIRO FORTEMENTE QUE você LEIA também OS FORUNS ACIMA PARA SE INFORMAR MAIS E DETECTAR EVENTUAIS DIVERGENCIAS DESSE POST COM OUTROS FORUNS. AS DIVERGENCIAS PERTINENTES EU COMENTEI DURANTE ESSE POST. CASO HAJA ALGUMA OUTRA DUVIDA, PESQUISE NOS FORUNS ANTES DE TENTAR REALIZAR ESSE PROCEDIMENTO. NÃO REALIZE ESSE PROCEDIMENTO ANTES DE TER 100% DE CERTEZA QUE COMPREENDEU TODAS AS ETAPAS.

Seguir o roteiro dos links acima apresenta inúmeras dificuldades, evitadas pelo guia que escrevo aqui. Primeiro há a dificuldade de se conseguir um conversor eletrônico Rs232-TTL no Brasil já montado certinho, segundo há discrepâncias sobre o procedimento entre os diferentes links. No final, o guia do www.msfn.org cujo link está acima é o mais confiável e completo mas não trata da solução usando um cabo de dados para celular do tipo CA-42.

Tente seguir solução postada aqui APENAS se o seu HD da seagate apresentar o seguinte defeito abaixo. Para o outro tipo de defeito, pesquise nos links acima (no total são apenas 2 tipos de defeito relacionados ao firmware da série 7200.11, e nesse guia eu trato de apenas 1 deles).

Também é importante testar se seu HDD de fato precisa de uma atualização do firmware. Veja isso no link abaixo:

http://seagate.custkb.com/seagate/cr...p?DocId=207931

O meu problema com HD da Seagate 7200.11

1) HD não é mais detectado na BIOS ao se ligar o computador, embora o HD ligue o motor dele e faça algum barulho no começo. A BIOS fica travada por um tempo e os dados do HD são inacessíveis. Isso nos outros fóruns se chama de problema do tipo BUSY. Tudo se passa como se o HDD não existisse.

-------------A Solução-----------------------------------------------

-------------Materiais necessários e onde comprar---------------------

*******Todos os endereços abaixo são de São Paulo - SP*********

1) Chave de fenda tipo TORX T6. O jogo de chave de fenda custa 20 reais e é encontrado facilmente em lojas de eletrônicos na rua Timbiras, perpendicular à R. Sta Ifigênia. É usado para desparafusar a placa verde do HD.

2) Cabo de dados para celular do tipo CA-42, você acha isso por 20 reais na rua Sta Ifigenia 261 Box 43. Ele substituirá o conversor RS232-TTL mencionado em outros fóruns. É possível também utilizar um cabo DKU-5 mas é bem mais complicado usar esse cabo porque ele tem mais fios e exige uso de multímetro para identificar a função de cada um dos fios. Recomendo fortemente comprar somente o cabo CA-42.

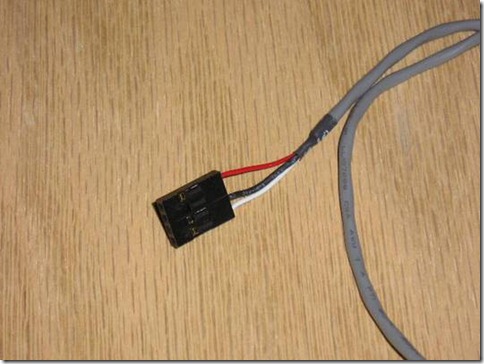

3) Conjunto de fios com conector MUDU na ponta (é o mesmo conector usado para conectar os botões do Gabinete na placa mãe). você pode usar os fios de um gabinete antigo ou comprar um set pronto em alguma loja. Poucas lojas vendem cabos desse tipo prontos e é irrelevante se os conectores mudu estão juntos ou separados pois iremos retirar os conectores MUDU da ponta, deixando apenas o revestimento metálico que fixa o fio ao conector MUDU. Comprei um conjunto de 3 fios prontos por 3 reais.

Fig.1 Essa foto mostra os fios com os conectores mudu

Fig. 2 Essa foto mostra os fios sem os conectores mudu

4) Soldador de 7 reais mais solda de 7 reais. É necessário para ligar os fios do cabo de dados CA-42 com os fios de conectores MUDU.

5) Fita isolante preta.

------------------------------------------------------------------------

---------------A confecção do cabo-------------------------------------

1) O cabo de dados CA-42 tem 2 pontas, uma ponta é USB que deixaremos intacta e a outra ponta é a do celular. Corte a ponta que conecta ao celular. Veja que o cabo tem 3 fios. Um deles chamaremos de RX, outro é o TY e por fim o GND (ground). Irei posteriormente explicar como identificar cada um desses fios.

2) Utilizando um estilete (não use tesoura), descasque o cabo que envolve os fios com finos cortes paralelos ao fio, até você conseguir enxergar um dos fios. A partir desse ponto, você pode com a mão puxar e cortar com uma tesoura o resto do encapamento revelando os 3 fios sem lesionar eles com o estilete. Quando os 3 fios estiverem expostos, faça um pequeníssimo corte com uma tesoura e puxe o encapamento deles para fora com a mão e unha.

3) Em seguida pegue os fios com os conectores mudu. Utilizando um estilete, é possível levantar uma fina aba do conector mudu a fim de liberar o fio preso a ele. Levante essa aba e puxe o fio gentilmente, fazendo isso com o restante dos fios, no total de 3.

4) Utilize o soldador e a solda com muito cuidado, seguindo as instruções do soldador, a fim de unir cada um fio desencapado do cabo de dados CA-42 com os fios do cabo que tinha os conectores mudu. Quando a solda esfriar, isole os fios soldados com uma fita isolante. No final, você terá 3 fios independentes devidamente soldados. Isso é importante para garantir um bom contato.

Agora iremos testar o cabo confeccionado e determinar quais terminais são RX, TY e GND.

-----------------------------------------------------------------------

-------------Testando o cabo------------------------------------------

1) Ligue o computador, conecte o cabo CA-42 no windows XP e instale os drivers necessários utilizando o cd que veio com o cabo de dados CA-42.

2) Vá ao painel de controle --> sistema ---> hardware --> gerenciador de dispositivos --> portas (COM & LPT) e ache qual porta COM está instalado o cabo CA-42.

3) Ligue o Hyperterminal (ausente no windows vista, consulte os links dos fóruns para uso de programas alternativos). Ignore as janelas que talvez apareçam clicando em ok ou cancelar. Vá em arquivos --> propriedades e escolha a porta COM correta em que está instalado o cabo CA-42. Depois vá em configurações e coloque BAUD 38400, Data BITs 0, Stop Bits 0, Parity none, Flow Control none. Clique em ok e saia da janela de configuração.

4) O objetivo agora é definir a função de cada fio, ou seja, qual fio é o RX, TY ou GND.

Quando o fio RX e TY são unidos, e algo é digitado no teclado, a janela do Hyperterminal mostra exatamente o que é escrito no teclado. Isso significa que o fio que sobrou é necessariamente o GND. Anote no papel qual fio é o GND.

Quando o fio GND encosta no fio RX caracteres estranhos aparecem na janela do Hyperterminal. Portanto sabemos qual fio é o RX. O fio que sobrou acaba sendo o TY. Anote tudo em um papel.

5) Isole os conectores metálicos na ponta com fita isolante, para evitar contato entre eles ao plugar eles no HD.

Portanto a partir desse ponto, fizemos a etapa mais trabalhosa do processo, que é comprar os materiais e confeccionar e testar o cabo. É muitíssimo importante que o cabo esteja funcionando exatamente como descrito acima e que ele esteja bem soldado para evitar perda de contato.

--------------------------------------------------------------------------

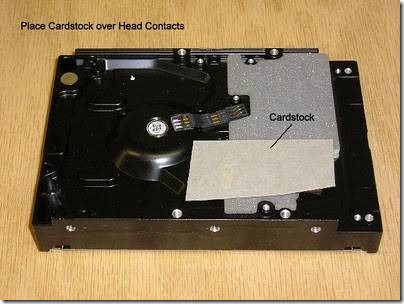

------------Preparando o HD----------------------------------------------

1) Primeiro se esfregue em uma superfície de metal para tirar a eletricidade estática do seu corpo. Vire o HD, você verá uma placa verde parafusada em diversos pontos (olhe as fotos). Desparafuse usando a chave de fenda TORX T6, retire a placa verde, arrume novamente a almofada que fica embaixo da placa verde. você verá que tem um conector metálico retangular na foto. Isole esse conector com um cartão comercial como mostrado na foto (recorte o cartão para diminuir o tamanho) e parafuse os 3 parafusos mais distantes desse conector como mostrado na foto.

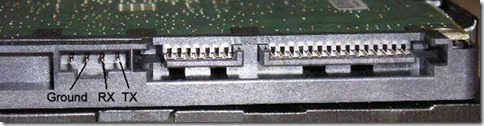

2) Com o computador desligado, conecte os cabos RX, TY, GND no HD como mostrado na foto, conecte também o cabo de energia sata no HD. NAO conecte o cabo de dados sata no HD. O HD deve estar de cabeça para baixo, devidamente fixo com fita isolante para evitar que ele se mexa e deve estar com fácil acesso e fora do gabinete.

Em um determinado momento futuro do processo, iremos retirar o cabo de força do HD SEM RETIRAR o cabo RX, TY e GND e portanto é importante que os fios não estejam enroscados entre si, assim como retiraremos posteriormente o pedaço de papel que colocamos embaixo da placa verde.

-------------------------------------------------------------------------

-----------------Inserindo os comandos no Hyperterminal------------------

Todos os comandos a serem digitados no Hyperterminal estão em vermelho! Note que é importante colocar os comandos exatamente como estão escritos aqui, tomando cuidado em usar letras maiúsculas ou minúsculas de acordo com o comando.

1) Ligue o computador, entre no windows, ligue e configure o hyperterminal da mesma forma quando o cabo foi testado, colocando as devidas configurações numéricas mencionadas antes e selecionando a porta COM correta como explicado antes. Se tudo estiver correto, ao se pressionar no teclado crtl+z você verá na janela do programa o seguinte prompt:

F3 T>

Caso você não veja nada é provável que os cabos RX e TY não estejam colocados da forma correta, talvez estejam invertidos ou com mal contato. Desligue o computador e rearrange os cabos da forma correta ou procure mal contatos etc e tente novamente.

Se tudo deu certo, então digite o comando em vermelho:

F3 T>/2 [tecle ENTER]

F3 2>Z [tecle ENTER]

Espere sair a mensagem:

Spin Down Complete

Elapsed Time 0.147 msecs

F3 2>

Nesse momento, com muito cuidado e com o HD ligado e todos os fios conectados, retire o pedaço de papel do HD que colocamos embaixo da placa verde e em seguida parafuse cuidadosamente os parafusos soltos que sobraram SEM QUE OS PARAFUSOS ENCOSTEM EM QUALQUER OUTRO LUGAR DA PLACA. Sugiro que use uma fita isolante de forma a fixar o parafuso na chave de fenda para evitar que o parafuso entre em contato com qualquer outra parte da placa verde. É normal que ao se retirar o papel, a almofada que fica embaixo da placa verde saia um pouco de lugar. Se preocupe em ajeitar a almofada somente depois que tudo terminar.

Depois, insira os comandos abaixo:

F3 2>U [tecle ENTER]

Espere a mensagem:

Spin Up Complete

Elapsed Time 7.093 secs

F3 2>

F3 2>/1 [tecle ENTER]

F3 1>N1 [tecle ENTER]

Cuidadosamente nesse ponto retire o cabo de força sata do HD com cuidado, SEM retirar os cabos RX, TY, GND, espere 10 segundos e reconecte de novo. Esse é um ponto em que os vários fóruns divergem, alguns não mencionam a necessidade de tirar o cabo de força nesse ponto o que eu considero um erro.

Isso deve ser feito SEM desligar o computador ou o windows e SEM sair do Hyperterminal.

Com o cabo de força do HD reconectado, pressione crtl+z e aparecera o prompt abaixo:

F3 T>

Digite o comando final em vermelho:

F3 T>m0,2,2,0,0,0,0,22 [tecle enter] [note que o "0" é zero e não a vogal o]

Depois de alguns segundos a um minuto, você deverá ver a mensagem abaixo:

Max Wr Retries = 00, Max Rd Retries = 00, Max ECC T-Level = 14, Max Certify Rewrite Retries = 00C8

User Partition Format 10% complete, Zone 00, Pass 00, LBA 00004339, ErrCode 00000080, Elapsed Time 0 mins 05 secs

User Partition Format Successful - Elapsed Time 0 mins 05 secs

Somente depois dessa mensagem você pode desligar o computador, desconectar todos os cabos, reinstalar os HD normalmente na placa mãe e ver se o problema foi resolvido.

Antes de atualizar o firmware de seu HDD, faça backup com DVDs, pois a atualização do firmware pode falhar, anulando todo o esforço de recuperar o HDD.

Caso não tenha sido resolvido, consulte os links dos fóruns acima para qualquer problema. Existe procedimentos extras para caso esse problema persista, mas não mencionarei nesse post porque eu não precisei realizar eles.

Comprei no camelô o "suposto" cabo CA-42, o qual foi reconhecido pelo WinXP como DKU-50 com 6 fios!!!... Fiquei meio preocupado, achando que não funcionaria, mas, como já havia retirado o conector, resolví prosseguir com o trabalho. Seguindo a dica de outro colega aqui do fórum, desmontei o conector que já havia retirado e identifiquei os fios soldados, separando-os para testes e identificação de RX, TX e GND.

Observação: Como não achei na configuração do HyperTerminal os valores "0" para Bit de Dados nem "0" para Bit de Parada, usei os populares "8", "N", "1" e "Nenhum" para Controle de Fluxo.

Bastou seguir o restante dos procedimentos para o HD Maxtor DiamondMax 22 - 500GB - STM3500320AS voltar a ser reconhecido pela BIOS e funcionar normalmente.

Quanto à possível dificuldade em "espetar" os 3 terminais MODU nos 3 pinos do HD, sugiro isolar apenas os dois terminas das extremidades, ficando o do meio sem isolamento e, portanto, ocupando menos espaço. (Claro que é necessário garantir que não haja contato entre eles)

Enfim, encorajo a qualquer um que tenha o mesmo tipo de "problema" com HD a seguir o conteúdo do tópico do Diakonov!

Mais links sobre este assunto:

http://seagate.custkb.com/seagate/crm/selfservice/search.jsp?DocId=207951&NewLang=en

http://forum.clubedohardware.com.br/erro-hd-seagate/699482

http://forum.clubedohardware.com.br/recuperacao-hd-seagate/696794

http://www.overclock.net/hard-drives-storage/457286-seagate-bricked-firmware-drive-fix-pics.html

http://www.msfn.org/board/topic/128807-the-solution-for-seagate-720011-hdds/page__st__1000

http://www.guiadohardware.net/comunidade/hd-problema/966710/1.html#post4373693

http://www.guiadohardware.net/comunidade/hd-problema/966710/9.html#post4490690